借着Kimi K2的小爆发,吐露一些近期对Model as Agent的小思考

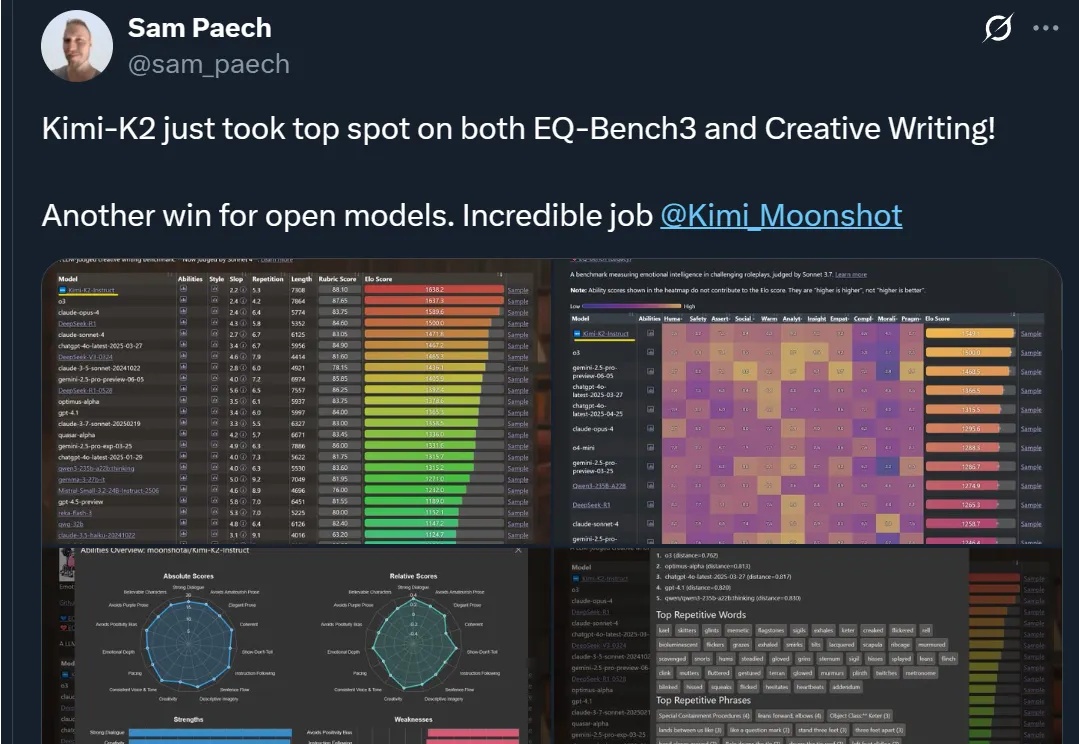

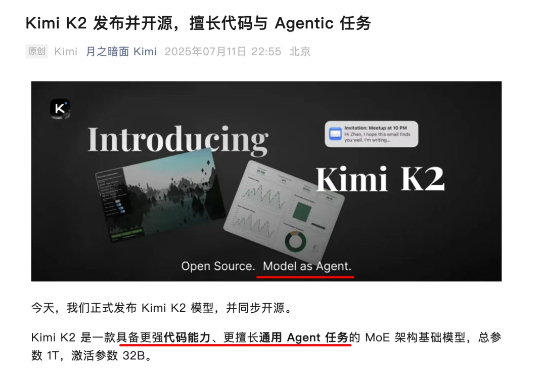

借着Kimi K2的小爆发,吐露一些近期对Model as Agent的小思考上周五(711),月之暗面蛰伏半年,憋了个大的,正式发布Kimi K2模型,总参数1T,同步开源。具体模型效果就不过多赘述了,网上已经有很多实测。

上周五(711),月之暗面蛰伏半年,憋了个大的,正式发布Kimi K2模型,总参数1T,同步开源。具体模型效果就不过多赘述了,网上已经有很多实测。

大家好,我是袋鼠帝 上周五kimi开源了他们最新最强的旗舰模型K2https://github.com/MoonshotAI/Kimi-K2。K2这几天很多博主都写过了,确实很强,如果能搭配世界最强AI编程神器Claude Code,那不得起飞啊!

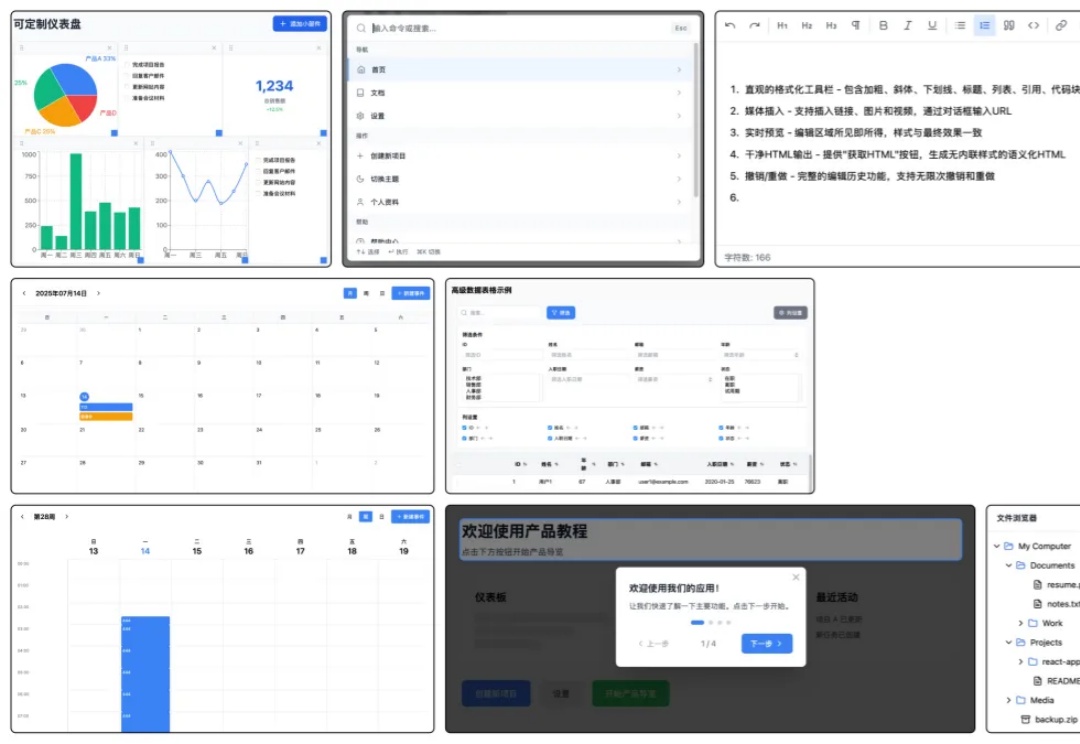

大家好,我是歸藏(guizang),今天展示一下我用 Kimi K2 实现的一套组件库,以及K2 替代 Claude Code 的默认模型的教程补充。

Kimi新模型热度持续高涨ing!

Kimi K2上线12小时,OpenAI就无限期推迟了下周的开源计划,给出的理由假到我都不想戳破他。

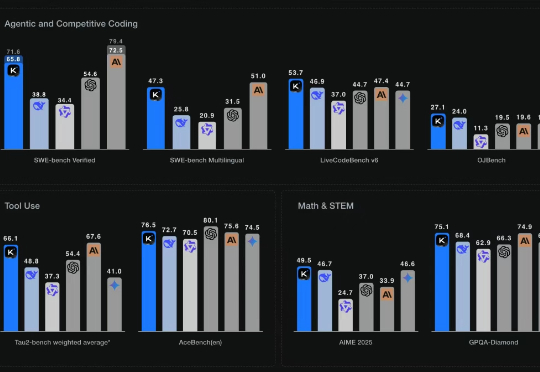

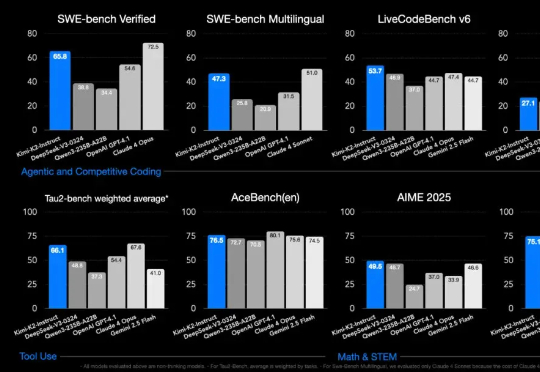

Kimi K2 发布了 2 天,我也测了足足 2 天。如果仔细观察 Kimi 这次的官方发布稿,不难发现 K2 强调的重点:Agent 与 Coding 能力。

美国AI初创公司 Perplexity 的联合创始人兼首席执行官Aravind Srinivas今日在社交平台发文,首次公开评价中国大模型“月之暗面”Kimi K2。他表示,Kimi K2 在内部测试中表现良好,Perplexity 正在考虑在其基础上进行后训练。

大家好,我是歸藏(guizang),熬夜给大家带来 Kimi K2 模型和提升K2模型的CC+K2邪修教程。大家好,我是歸藏(guizang),熬夜给大家带来 Kimi K2 模型和提升K2模型的CC+K2邪修教程。

故事的开始是发生在 1 年多前,硅谷发生了令人震惊的杀妻案件。凶手用拳头一拳拳打死了自己的妻子,再加上 华人、高学历、清华、大厂这样的无敌光环,这件案子当时格外引人关注。

最近,Kimi Researcher(深度研究)开启内测。根据官方介绍,其定位并非一个简单的“搜索工具”,而是一个能够生成带引用来源的深度研究报告的AI Agent。